38と46のリビジョン間の差分 (その間の編集: 8回)

|

サイズ: 35988

コメント:

|

サイズ: 34076

コメント:

|

| 削除された箇所はこのように表示されます。 | 追加された箇所はこのように表示されます。 |

| 行 2: | 行 2: |

[Japanese|[[en/ClusterSystemUsage|English]]] |

|

| 行 3: | 行 6: |

| [[ClusterSystem|次世代シミュレーション技術教育計算機システム]]と[[WideAreaClusterSystem|広域連携教育研究用クラスタシステム]]に共通する利用方法について解説します. 各システムの個別情報については,それぞれのシステムのページを確認してください. | [[WideAreaClusterSystem|広域連携教育研究用クラスタシステム]]の利用方法について解説します. |

| 行 8: | 行 11: |

| * [[ClusterSystem|次世代シミュレーション技術教育計算機システム]] | /* * [[ClusterSystem|次世代シミュレーション技術教育計算機システム]]*/ |

| 行 185: | 行 188: |

| * [[ClusterSystem|次世代シミュレーション技術教育計算機システム]] | |

| 行 538: | 行 540: |

=== ANSYS HFSSジョブ === [[attachment:ansys-hfss-16.1-manual.pdf|ANSYS HFSS利用マニュアル]]に利用方法の詳細が説明されています。 そちらをご参照下さい。 |

|

| 行 1037: | 行 1044: |

| ① Materials Studio Visualiserからスパコンに対しジョブを投入する | ① Materials Studio Visualiserからスパコンに対しジョブを投入する(Materials Studio2016のみ対応) |

| 行 1066: | 行 1073: |

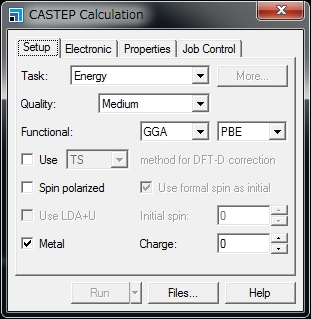

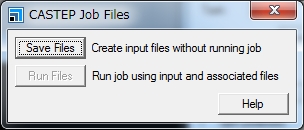

{{{ ### sample #!/bin/sh #PBS -l nodes=1:ppn=8 #PBS -q rchq MPI_PROCS=`wc -l $PBS_NODEFILE | awk '{print $1}'` cd $PBS_O_WORKDIR cp /common/accelrys/cdev0/MaterialsStudio8.0/etc/CASTEP/bin/RunCASTEP.sh . perl -i -pe 's/\r//' * ./RunCASTEP.sh -np $MPI_PROCS acetanilide }}} * RunCASTEP.shの第3引数は,転送したフォルダ内のファイル名を指定してください.拡張子は必要ありません. * 「ppn=」は,8以下,の値を指定してください. * 経過時間制限値,メモリ利用容量制限値は必要に応じて変更できます. * 「CASTEP Calculation」ウィンドウの”Job Control”タブにおける「Gateway location」「Queue」「Run in parallel on」の設定はコマンドライン実行に対し意味を持ちません.qsubコマンド時に利用する実行スクリプト内の設定が用いられます. * 実行スクリプトは利用する計算機や計算モジュールにより異なります.下記の「実行スクリプト例」をご参照ください. '''4. ジョブ終了後、計算結果ファイルをクライアントPCに転送し,Materials studio Visualizerを利用して閲覧してください.''' '''共同利用に関する注意事項''' Materials Studioのライセンスは,CASTEP:8本,Dmol3:8本,を所有しています.1ライセンスで8並列以下のジョブを1つ実行することができます.本ライセンスは共用です.他のユーザーと競合しないように留意の上,ご利用をお願いします. '''実行スクリプト例''' 次世代シミュレーション技術教育計算機システムでMaterials Studio 8.0 CASTEPを実行する場合: |

|

| 行 1127: | 行 1094: |

次世代シミュレーション技術教育計算機システムでMaterials Studio 8.0 DMOL3を実行する場合: {{{ ### sample #!/bin/sh #PBS -l nodes=1:ppn=8,mem=24gb,pmem=3gb,vmem=24gb,pvmem=3gb #PBS -l walltime=24:00:00 #PBS -q rchq MPI_PROCS=`wc -l $PBS_NODEFILE | awk '{print $1}'` cd $PBS_O_WORKDIR cp /common/accelrys/cdev0/MaterialsStudio8.0/etc/DMol3/bin/RunDMol3.sh . perl -i -pe 's/\r//' * ./RunDMol3.sh -np $MPI_PROCS acetanilide }}} 次世代シミュレーション技術教育計算機システムでMaterials Studio 2016 CASTEPを実行する場合: {{{ ### sample #!/bin/sh #PBS -l nodes=1:ppn=8,mem=24gb,pmem=3gb,vmem=24gb,pvmem=3gb #PBS -l walltime=24:00:00 #PBS -q rchq MPI_PROCS=`wc -l $PBS_NODEFILE | awk '{print $1}'` cd $PBS_O_WORKDIR cp /common/accelrys/cdev0/MaterialsStudio2016/etc/CASTEP/bin/RunCASTEP.sh . perl -i -pe 's/\r//' * ./RunCASTEP.sh -np $MPI_PROCS acetanilide }}} 次世代シミュレーション技術教育計算機システムでMaterials Studio 2016 DMOL3を実行する場合: {{{ ### sample #!/bin/sh #PBS -l nodes=1:ppn=8,mem=24gb,pmem=3gb,vmem=24gb,pvmem=3gb #PBS -l walltime=24:00:00 #PBS -q rchq MPI_PROCS=`wc -l $PBS_NODEFILE | awk '{print $1}'` cd $PBS_O_WORKDIR cp /common/accelrys/cdev0/MaterialsStudio2016/etc/DMol3/bin/RunDMol3.sh . perl -i -pe 's/\r//' * ./RunDMol3.sh -np $MPI_PROCS acetanilide }}} |

* RunCASTEP.shの第3引数は,転送したフォルダ内のファイル名を指定してください.拡張子は必要ありません. * 「ppn=」は,8以下,の値を指定してください. * 経過時間制限値,メモリ利用容量制限値は必要に応じて変更できます. * 「CASTEP Calculation」ウィンドウの”Job Control”タブにおける「Gateway location」「Queue」「Run in parallel on」の設定はコマンドライン実行に対し意味を持ちません.qsubコマンド時に利用する実行スクリプト内の設定が用いられます. * 実行スクリプトは利用する計算機や計算モジュールにより異なります.下記の「実行スクリプト例」をご参照ください. '''4. ジョブ終了後、計算結果ファイルをクライアントPCに転送し,Materials studio Visualizerを利用して閲覧してください.''' '''共同利用に関する注意事項''' Materials Studioのライセンスは,CASTEP:8本,Dmol3:8本,を所有しています.1ライセンスで8並列以下のジョブを1つ実行することができます.本ライセンスは共用です.他のユーザーと競合しないように留意の上,ご利用をお願いします. '''実行スクリプト例''' |

[Japanese|English]

クラスタシステムの利用方法

広域連携教育研究用クラスタシステムの利用方法について解説します.

目次